机器学习常见领域记录

机器学习记录

之前做过一篇偏课内的笔记 机器学习复习 - I am LiHua

半监督学习&自监督学习

一文看懂半监督学习(Semi-supervised Learning)和自监督学习(Self-Supervised Learning)

将大量的无类标签的样例加入到有限的有类标签的样本中一起训练来进行学习,期望能对学习性能起到改进的作用

自监督学习是一种无监督学习的方法

对比学习

【深度学习:(Contrastive Learning) 对比学习】深入浅出讲解对比学习

在学习到的嵌入空间中,相似的实例应靠得更近,而不相似的实例应离得更远

对比学习是自监督学习的一个子集

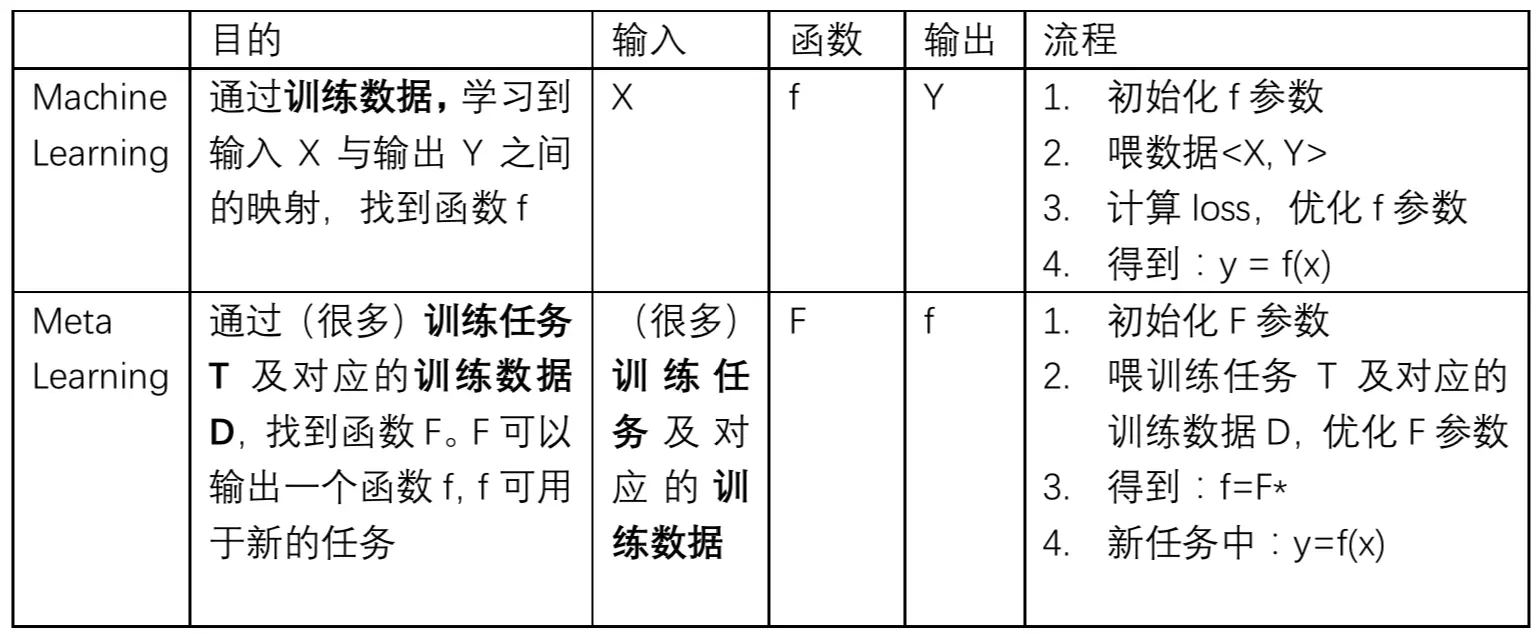

元学习

二者的目的都是找一个Function,只是两个Function的功能不同,要做的事情不一样。机器学习中的Function直接作用于特征和标签,去寻找特征与标签之间的关联;而元学习中的Function是用于寻找新的f,新的f才会应用于具体的任务。

有点像 普通方程和微分方程的区别

小样本学习

【学习笔记】小样本学习(Few-shot Learning)_小样本训练

可以学习一个相似度函数sim(x,x’) 来判定样本x和x’的相似度,相似度越高,表示这两个样本越可能是同一个类别。例如,可以通过一个很大的数据集学习出一个相似度函数,然后用该函数进行预测。

元学习可以用于小样本学习

迁移学习

将某个领域或任务上学习到的知识或模式应用到不同但相关的领域或问题中。

会看源数据和目标数据的分布差别/使用共享参数这样的方法

大模型的微调

文章探讨了大型模型微调的技术手段,包括全面微调和参数高效微调(PEFT),并详细介绍了PEFT中的各种方法,如LoRA、QLoRA、适配器调整、前缀调整、提示调整、P-Tuning及P-Tuning v2等。

大模型的微调是迁移学习的一种形式

五万字综述!Prompt-Tuning:深度解读一种新的微调范式 - 知乎

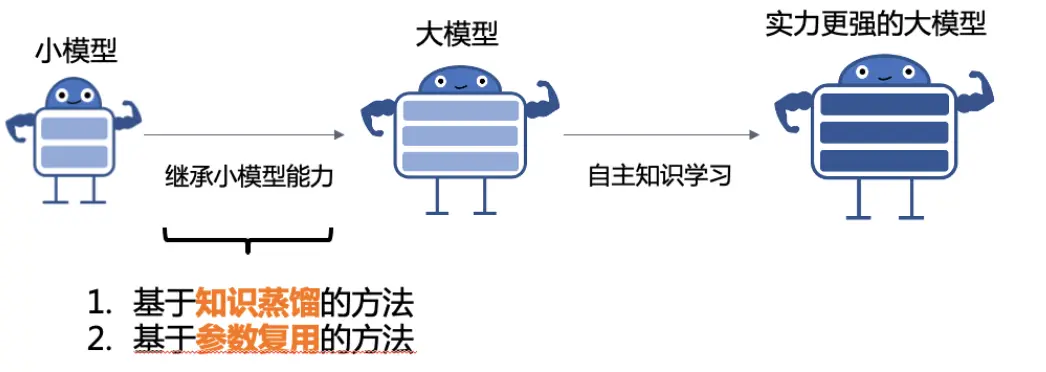

增量学习

- 正则化(比如权重正则化,让新任务学习的时候限制部分权重的变化

- 回放(回放之前任务的代表样本

- 优化(如结合新任务的梯度和老任务的梯度找一个都适合的梯度

- 特征(让模型记住特征而不是样本

- 架构(根据新任务,让模型参数变多